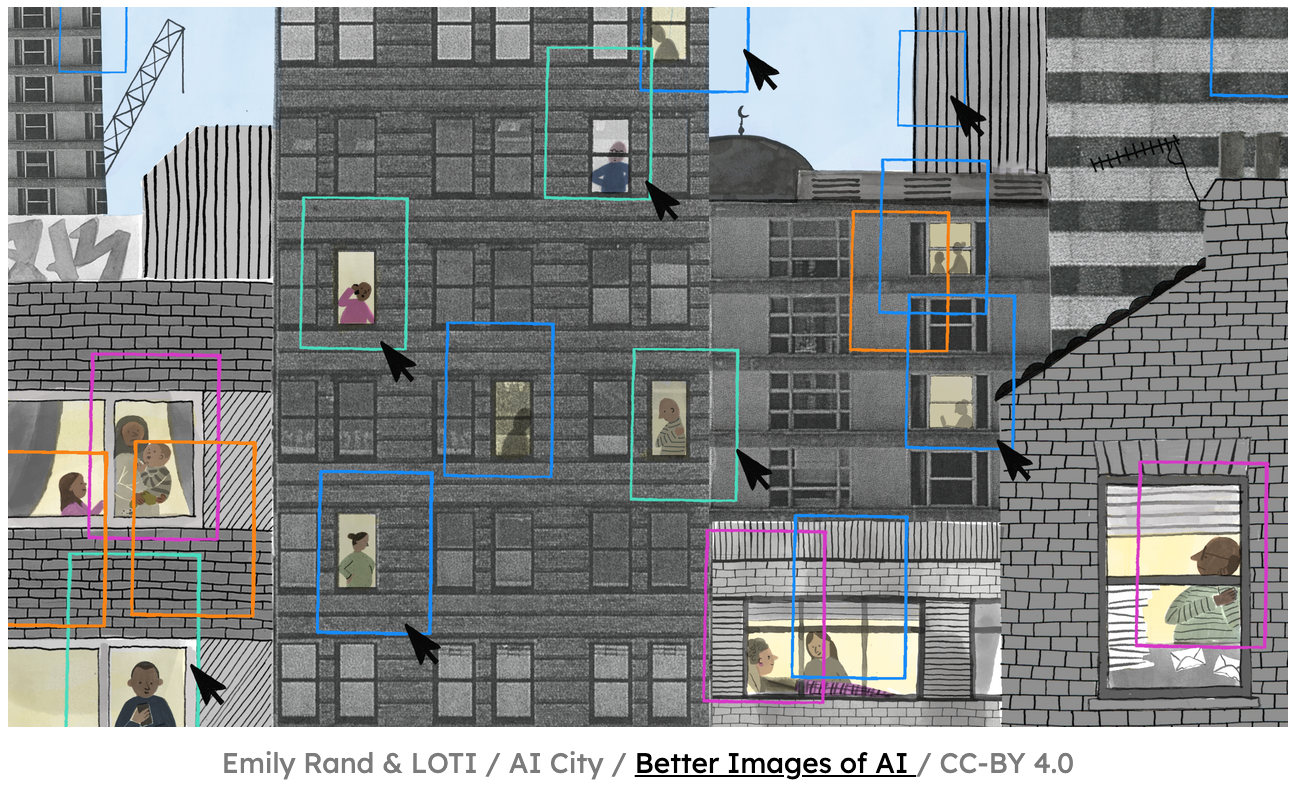

Cette analyse révèle un mécanisme pervers : quand les administrations automatisent leurs décisions pour gagner en 'objectivité', elles industrialisent en réalité la discrimination. L'exemple néerlandais du scandale des allocations familiales (toeslagenaffaire) illustre parfaitement cette mécanique : un système conçu pour détecter la fraude a ciblé systématiquement les familles à double nationalité et à faibles revenus, non par malveillance mais par conception. L'algorithme, entraîné sur des données historiques saturées de biais de surveillance, a transformé la corrélation en causalité.

"Pour les communautés marginalisées, la menace n'est pas que la technologie échoue, mais qu'elle fonctionne exactement comme prévu, démultipliant la discrimination systémique que les politiques publiques sont censées atténuer [traduit de l'anglais]"

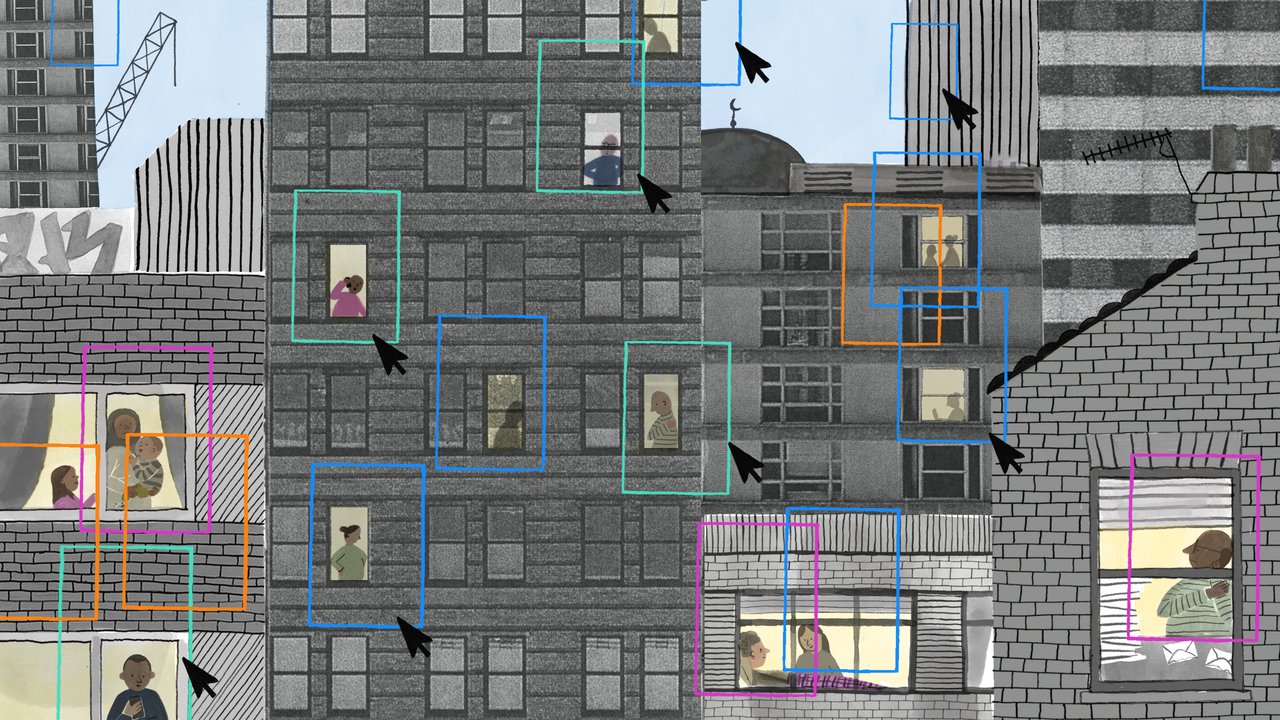

Ce qui se dessine, c'est un nouveau régime de gouvernement par les données où la discrimination devient invisible car technique. Les systèmes de recrutement automatisé reproduisent l'homogénéité des équipes existantes en pénalisant les parcours non-conformes, sans jamais mentionner explicitement la race ou le handicap. Ils utilisent des 'proxies' — codes postaux, trous dans l'emploi, patterns linguistiques — qui fonctionnent comme des marqueurs sociaux déguisés.

"Le danger de ces systèmes réside dans leur capacité à blanchir les décisions politiques à travers des processus techniques. En présentant l'allocation et l'application de la loi comme des problèmes d'ingénierie, les institutions peuvent éviter l'examen moral et juridique qui accompagne habituellement les changements de politique [traduit de l'anglais]"

L'asymétrie de pouvoir est totale : l'individu rejeté fait face à une boîte noire propriétaire, sans accès au score qui l'a disqualifié ni aux données d'entraînement. Cette opacité rend la contestation quasi impossible, isolant de fait les organisations déployeuses de toute responsabilité. Ce qui émerge n'est plus de la gouvernance mais une forme de 'phrénologie numérique' qui infère le caractère à partir de traces comportementales superficielles.

Points de vigilance : Risque de paralysie analytique si l'on se contente de critiquer sans proposer d'alternatives concrètes. L'audit technique peut devenir un alibi si les objectifs politiques sous-jacents restent inchangés.

8/10 : Score sur l'échelle des "5 piliers de la liberté", inspiré de l'ouvrage de Timothy Snyder

Et maintenant ?

🤘 Créer des observatoires citoyens de l'algorithme public par secteur

Alliance juristes-chercheurs-syndicats pour auditer systématiquement les algorithmes publics. Mécanisme : droit d'accès collectif aux données d'entraînement, publication obligatoire des résultats d'audit, recours collectifs facilités. Coalition : associations de défense des droits, syndicats de fonctionnaires, universités, médias d'investigation.

→ On saura que ça marche quand les administrations publieront proactivement les audits de leurs algorithmes avant leur déploiement, et qu'au moins 3 systèmes discriminatoires auront été retirés suite à des contestations collectives documentées.

🤘 Transformer l'opacité algorithmique en transparence par l'action juridique

Stratégie coordonnée de recours collectifs ciblant les 'boîtes noires' les plus critiques. Mécanisme : mutualiser les coûts juridiques, partager les preuves techniques, créer une jurisprudence contraignante. Effet de levier : chaque victoire judiciaire force la transparence sur tout un secteur d'algorithmes similaires.

→ On saura que ça marche quand les entreprises tech et les administrations négocieront des accords de transparence pour éviter les class actions, et que les audits algorithmiques deviendront un standard d'achat public.

💪 Documenter collectivement les décisions algorithmiques subies

Créer des bases de données citoyennes des décisions algorithmiques (refus de crédit, d'emploi, d'aide sociale) pour révéler les patterns discriminatoires invisibles. Mécanisme : applications de signalement anonymisées, analyse statistique collaborative, transmission aux régulateurs. Effet multiplicateur : plus il y a de données, plus les biais deviennent évidents et contestables.

→ On saura que ça marche quand au moins 10 000 décisions algorithmiques seront documentées dans une base ouverte, et que les premières enquêtes journalistiques utiliseront ces données pour révéler des discriminations systémiques.

Ces pistes ne sont pas des recettes toutes faites, mais des points d'entrée pour repenser nos systèmes numériques selon une logique de liberté positive : non pas limiter, mais augmenter nos capacités collectives d'action.

Si tu connais des exemples réels qui vont dans ce sens — ou des contre-exemples qui méritent d'être documentés — partage-les en commentaires et discutons-en ensemble sur Discord !

Cinq piliers pour prendre soin de nos libertés numériques