Cette semaine, 404 Media a révélé l'existence d'ELITE — Enhanced Leads Identification & Targeting for Enforcement. Un outil développé par Palantir pour ICE qui agrège des données provenant de multiples sources gouvernementales — dont les informations de près de 80 millions de bénéficiaires Medicaid — pour générer des cartes de ciblage interactives.

L'application affiche une carte type Google Maps, mais au lieu de restaurants, elle localise des êtres humains. Chaque cible dispose d'un dossier complet : photo, date de naissance, numéro d'enregistrement — et un "score de confiance" de 0 à 100 sur la probabilité qu'elle se trouve bien à l'adresse indiquée.

Le mécanisme est simple : vous vous inscrivez à Medicaid pour accéder à des soins. Le département de la Santé transmet vos coordonnées au département de la Sécurité intérieure. Palantir les agrège avec des dizaines d'autres bases de données — fiscales, biométriques, réseaux sociaux. Et un agent ICE trace un périmètre sur une carte pour cibler une zone d'intervention.

Ce n'est plus de la surveillance. C'est une fusion infrastructurelle.

Je m'appelle Damien Van Achter, Je suis journaliste, prof et consultant en innovation et en pédagogie entrepreneuriale. Depuis 2005, j'essaye de comprendre et de raconter comment fonctionnent nos systèmes informationnels.

Au cours du temps, j'ai développé des outils d'analyse qui repèrent les pièges tendus par les entreprises de la tech et certains états, et j'explore des pistes pour tenter de s'en libérer, positivement et avec discernement.

J'explique ici ma démarche, inspirée récemment des travaux de l'historien Timothy Snyder, comment ces analyses sont produites techniquement et humainement, ainsi que leurs limites.

On t'a transféré ce mail ? Tu peux t'abonner en 1 clic pour recevoir les suivants.

Tu as des remarques, des suggestions, ou tu veux discuter d'une idée pour avancer dans tes propres projets ? Jette un oeil à mon agenda. 📆

@davanac

🎯 à lire absolument cette semaine

L'État-plateforme américain

Le département de la Sécurité intérieure (DHS) déploie actuellement près de 3 000 agents fédéraux à Minneapolis — la plus grande opération de son histoire — contre la volonté des élus locaux. Seth Stodder, ancien responsable de la politique frontalière sous Bush et Obama, résume ce qu'il observe : "En créant le DHS, nous ne voulions pas créer le KGB ou le FSB. Voir soudainement cette agence devenir un mécanisme d'intimidation autoritaire est désorientant et effrayant."

L'agence créée après le 11-Septembre pour protéger les Américains du terrorisme étranger publie désormais des images fantasmant "100 millions d'expulsions" et qualifie de "terrorisme domestique" les actions de Renee Nicole Good — cette mère de famille américaine abattue par un agent ICE à Minneapolis. Six procureurs fédéraux du Minnesota ont d'ailleurs démissionné en protestation contre la direction de l'enquête.

Pendant ce temps, le FBI perquisitionne le domicile d'une journaliste du Washington Post. Hannah Natanson s'est vu confisquer ordinateurs, téléphone et montre connectée. Dès le lendemain, 31 organisations — de l'EFF à l'ACLU en passant par le syndicat NewsGuild-CWA — ont signé une lettre commune réclamant la convocation de la ministre de la Justice devant le Congrès.

Et le Pentagone ? Il vient d'intégrer Grok — l'IA d'Elon Musk — sur ses réseaux classifiés. Pourquoi Grok ? Parce que c'est l'IA la moins bridée : la seule à accepter de donner des conseils opérationnels pour une invasion hypothétique du Groenland, là où ChatGPT et Gemini refusent. Pete Hegseth, secrétaire à la Défense, l'assume : "L'IA du Pentagone ne sera pas woke et fonctionnera sans contraintes idéologiques."

La même IA qui génère plus de 6 700 images sexuelles non-consenties par heure. La même qui reste disponible sur les stores Apple et Google malgré les demandes de retrait de 28 organisations et la génération documentée de contenus pédocriminels. Après le meurtre de Renee Nicole Good, Grok a même généré des images de son corps en bikini, y compris avec sa blessure par balle visible.

Le bluff économique de l'IA en toile de fond

Pendant que cette fusion s'opère, l'IA ne produit même pas ce qu'elle promet. J.P. Gownder, vice-président et analyste principal chez Forrester, applique à l'IA ce qu'il appelle le Paradoxe de Solow : malgré des investissements massifs, aucune donnée ne confirme l'augmentation de productivité promise. "On commence à comprendre que les technologies de l'information ne se traduisent pas toujours de manière aussi linéaire en productivité. Les gains ne sont tout simplement pas là."

95% des entreprises ayant intégré l'IA générative n'observent aucune croissance significative de revenus, malgré 30 à 40 milliards de dollars d'investissements (étude MIT NANDA, août 2025). Les programmeurs expérimentés utilisant des outils d'IA deviennent 19% moins performants — tout en croyant être 20% plus rapides (étude METR, juillet 2025).

Ce décalage révèle une asymétrie structurelle : les entreprises tech captent la valeur financière (investissements, valorisations boursières) tandis que les utilisateurs absorbent les coûts cachés — formation insuffisante (26% seulement des organisations forment leurs employés au prompt engineering), correction des erreurs (9% du temps développeur passé à nettoyer le code IA), dégradation de la qualité (67% des pull requests IA rejetées contre 16% pour le code humain).

Le bluff économique sert de paravent à la concentration de pouvoir.

L'infrastructure est déjà là

Et l'Europe ? Les mêmes outils Palantir sont déjà déployés chez nous. En France, la DGSI utilise Gotham depuis 2016 — contrat renouvelé pour trois ans en décembre 2025, « dans l'attente d'un outil souverain » qui n'arrive jamais. En Allemagne, la police de Hesse opère hessenDATA depuis 2017, rejointe par la Rhénanie-du-Nord-Westphalie en 2020 et la Bavière fin 2024.

Au Royaume-Uni, le NHS a signé un contrat de 330 millions de livres sur sept ans pour confier les données de santé de millions de Britanniques à Palantir — mais moins d'un tiers des hôpitaux l'utilisaient encore mi-2025, beaucoup jugeant le logiciel « moins performant » que leurs systèmes existants.

Les douanes norvégiennes utilisent Gotham pour cibler passagers et véhicules. La police danoise a quant à elle déployé une version personnalisée du logiciel, POL-INTEL, opérationnelle depuis 2017. Europol a testé le logiciel dans sa Task Force Fraternité, créée après les attentats de Paris de novembre 2015 — avec des résultats jugés décevants en interne : selon des documents obtenus par des journalistes, l'agence a envisagé une action en justice contre l'entreprise, notamment en raison de difficultés à visualiser de grands ensembles de données.

Enfin, l'OTAN elle-même a choisi Palantir pour son Allied Command Operations, le centre névralgique de planification militaire de l'Alliance, avec un contrat signé en mars 2025.

Palantir was honored to host Belgium’s Minister of Defence, Theo Francken, and Chief of Defence, Frederik Vansina, as part of the the Belgium Defence delegation’s visit to the U.S.

— Palantir (@PalantirTech) October 6, 2025

“Palantir is at the frontline of Europe’s defence and an important partner for all the members of… pic.twitter.com/U7qa9zToTS

La différence avec les États-Unis ? Un cadre juridique qui résiste — pour l'instant.

En février 2023, la Cour constitutionnelle fédérale allemande a déclaré l'usage de Palantir par la police de Hesse et Hambourg inconstitutionnel. Motif : violation du droit à l'autodétermination informationnelle. La loi permettait de créer des profils complets de personnes "en un seul clic", sans distinguer suspects et innocents — témoins, avocats, passants, tous aspirés dans la même base.

Mais la Hesse a simplement réécrit sa loi, et la GFF a déposé une nouvelle plainte en juin 2024, estimant que la version amendée reste inconstitutionnelle. La Bavière, elle, a testé le logiciel avec des données réelles avant même de disposer d'une base légale claire. Et le gouvernement Merz, via son ministre de l'Intérieur Alexander Dobrindt (CSU), envisage désormais de l'étendre au niveau fédéral — un revirement par rapport à la position de sa prédécesseure Nancy Faeser, qui avait bloqué le projet en 2023.

En France, aucun débat public sur le renouvellement du contrat DGSI. Au Royaume-Uni, le déploiement NHS avance malgré le scepticisme du personnel soignant.

L'infrastructure du contrôle n'est pas un futur dystopique américain à éviter. Elle est déjà installée sur notre sol.

Et il a suffi d'un changement politique aux États-Unis pour transformer les données Medicaid en cartes de déportation.

La résistance s'organise

Face à cette fusion État-Tech, une résistance multi-front émerge — des deux côtés de l'Atlantique.

L'Europe offensive existe — mais c'est la Commission européenne, pas les États membres, qui mène la charge. En décembre 2025, Bruxelles a infligé 120 millions d'euros d'amende à X pour violation du Digital Services Act — première sanction majeure sous ce nouveau règlement.

L'Irlande, elle, illustre plutôt les limites du modèle : comme le déplore Cory Doctorow, Dublin est devenue un "havre de l'impunité" pour les géants tech qui fuient le RGPD en s'y déclarant. La leçon stratégique est inverse : un petit pays peut transformer l'ordre mondial — mais l'Irlande a choisi de le faire au service des multinationales, pas contre elles.

Côté innovation juridique, la Cour de Justice de l'Union européenne avance sur un terrain plus subtil. Dans son arrêt de novembre 2025 sur les données policières tchèques, elle a distingué les marqueurs ADN d'identification pure des informations révélant l'ethnicité ou la santé — une nuance que des chercheurs européens qualifient de premier pas vers un concept de "données génométriques". L'Europe qui crée des catégories plutôt que de subir celles des autres.

De l'intérieur des géants tech. Plus de 150 employés de Meta, Google, Amazon, OpenAI, TikTok et d'autres entreprises ont signé une pétition exigeant que leurs dirigeants condamnent les violences d'ICE. Jeff Dean, directeur scientifique de Google DeepMind, partage ouvertement des posts critiquant ces pratiques. Nikhil Thorat, ingénieur chez Anthropic, déclare : "Les fondements moraux de la société moderne sont infectés et suppurent" — et compare la situation à un "cosplay de l'Allemagne nazie".

Plus radical encore : des employés d'entreprises d'IA ont lancé "Poison Fountain", un projet pour saboter les modèles en injectant des données corrompues — du code truffé d'erreurs logiques subtiles — dans les sources d'entraînement. Leur manifeste cite Geoffrey Hinton : "L'intelligence artificielle est une menace pour l'espèce humaine."

Des citoyens sur le terrain. À Minneapolis, un ingénieur logiciel a organisé le financement participatif de plus de 500 dashcams pour équiper les observateurs communautaires qui documentent les opérations ICE. La juge fédérale Kate Menendez a statué que suivre les véhicules d'ICE à distance sécuritaire ne justifie pas un contrôle routier, protégeant l'observation citoyenne au nom des Premier et Quatrième Amendements. L'EFF publie des guides d'autodéfense numérique pour les communautés ciblées — comment protéger ses données, sécuriser ses communications, documenter les abus sans se mettre en danger.

Des institutions qui tiennent. Plus de 25 localités américaines ont adopté des lois de contrôle citoyen sur la surveillance policière, exigeant transparence et audits citoyens avant tout achat de technologie de surveillance. 31 organisations — de l'EFF à l'ACLU en passant par le syndicat NewsGuild-CWA — ont signé en moins de 48 heures une lettre commune condamnant la perquisition du FBI chez la journaliste du Washington Post Hannah Natanson.

La résistance naît au cœur même des structures complices — et elle commence à se coordonner.

⚡ des pistes d'action concrètes

🎯 Quick wins (ce mois-ci)

- Auditer ses traces dans les bases gouvernementales. En Europe, le RGPD garantit un droit d'accès (Article 15) : vous pouvez demander à toute administration quelles données elle détient sur vous et comment elles sont utilisées. La police allemande utilise Palantir depuis 2017, la DGSI française depuis 2016, le NHS britannique depuis 2023. Savoir ce qui existe sur vous est le premier pas pour contester son usage — et la Cour constitutionnelle allemande a prouvé en 2023 que ces contestations peuvent gagner.

- Exiger la distinction génométrique. Lors de tout prélèvement ADN (enquête policière, test médical, généalogie), demander explicitement que seules les données d'identification soient conservées — pas les informations de santé ou d'origine ethnique. La CJUE vient de créer ce droit : autant l'exercer avant qu'il ne soit grignoté.

- Cartographier les dépendances institutionnelles. Documenter les contrats entre vos institutions locales (mairies, hôpitaux, universités) et les entreprises tech dont les dirigeants restent silencieux face aux dérives. 23 localités américaines ont déjà politisé ces achats en 2025 — le modèle est réplicable partout.

🌱 Long terme (1-2 ans)

- Coalitions transnationales de travailleurs tech. Structures permanentes reliant employés européens et américains pour coordonner résistances internes et pressions externes. Le modèle existe : 150 employés de Meta, Google, Amazon et Anthropic ont signé ensemble contre ICE — il faut transformer ces signatures en organisation durable avec capacité de blocage technique.

- Standard européen génométrique contraignant. Transformer le concept juridique de la CJUE en norme technique opposable, avec audit indépendant des bases de données policières existantes. L'Europe a inventé la catégorie — elle doit maintenant l'imposer comme standard mondial avant que d'autres ne la vident de sa substance.

- Coalitions transversales sur la finalité des données. Alliance organisations de santé + associations d'immigrés + défenseurs de la vie privée pour contester juridiquement tout détournement de données collectées à des fins spécifiques. ELITE montre que les données Medicaid deviennent des cartes de déportation — chaque secteur (éducation, transports, énergie) doit anticiper ce type de détournement.

→ On saura que ça avance quand les appels d'offres technologiques incluront systématiquement des clauses de limitation de finalité et d'audit citoyen.

📚 si tu les as manqués

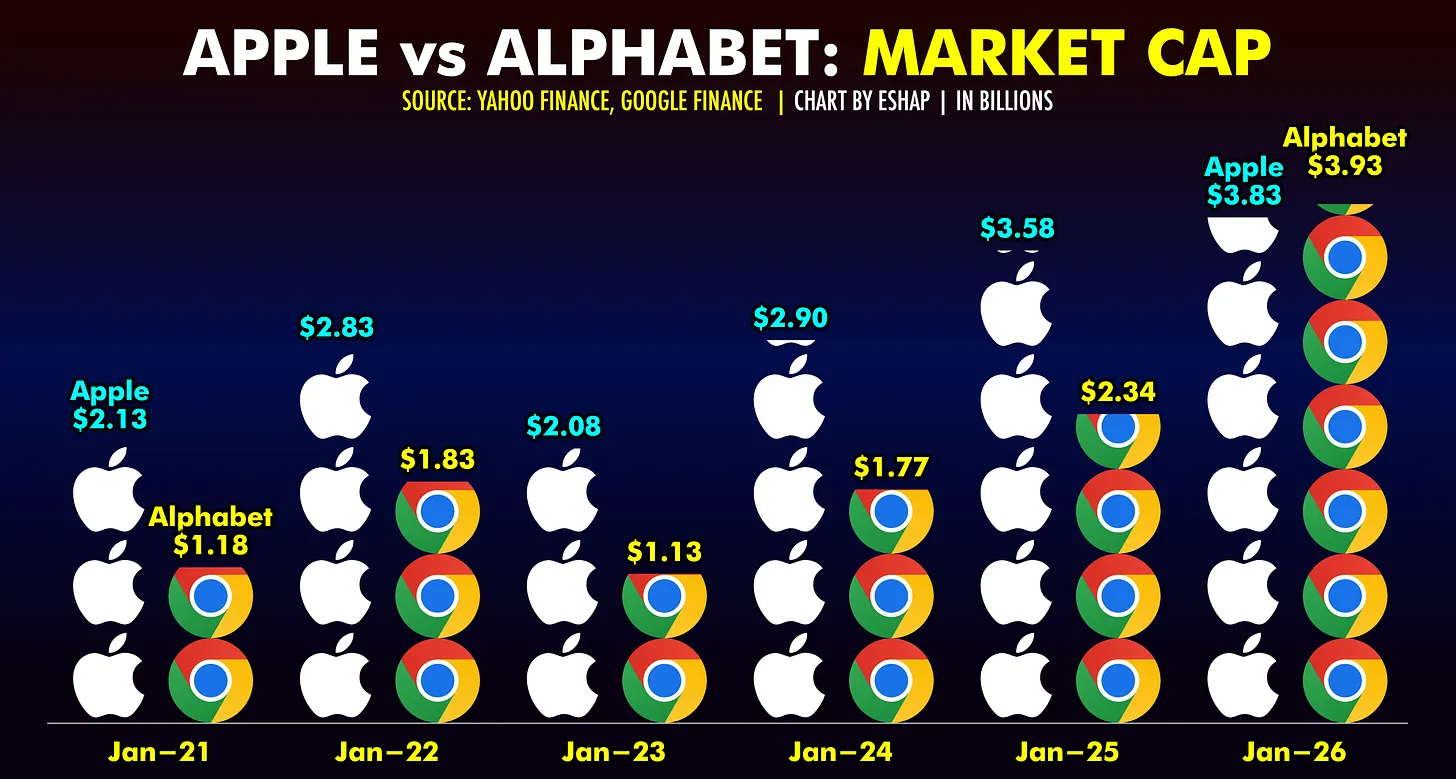

Google devient plus valorisé qu'Apple grâce à son écosystème d'intelligence artificielle intégré verticalement. L'ère iPhone se termine, celle de l'IA-monopole commence.

Pour la première fois, l'UE reconnaît que la précarité des journalistes menace directement l'accès des citoyens à une information libre et indépendante.

Face aux projets d'interdiction des réseaux sociaux aux mineurs, experts et chercheurs démontent méthodiquement les arguments de la 'génération anxieuse' et plaident pour l'éducation plutôt que la répression.

Enfin, j'ai eu le plaisir d'intervenir au JT de la RTBF pour évoquer les 25 ans de Wikipédia, alors que la Wikimedia Foundation vient d'annoncer des partenariats commerciaux avec Amazon, Meta, Microsoft, Perplexity et Mistral rejoignent Google dans le programme Wikimedia Enterprise

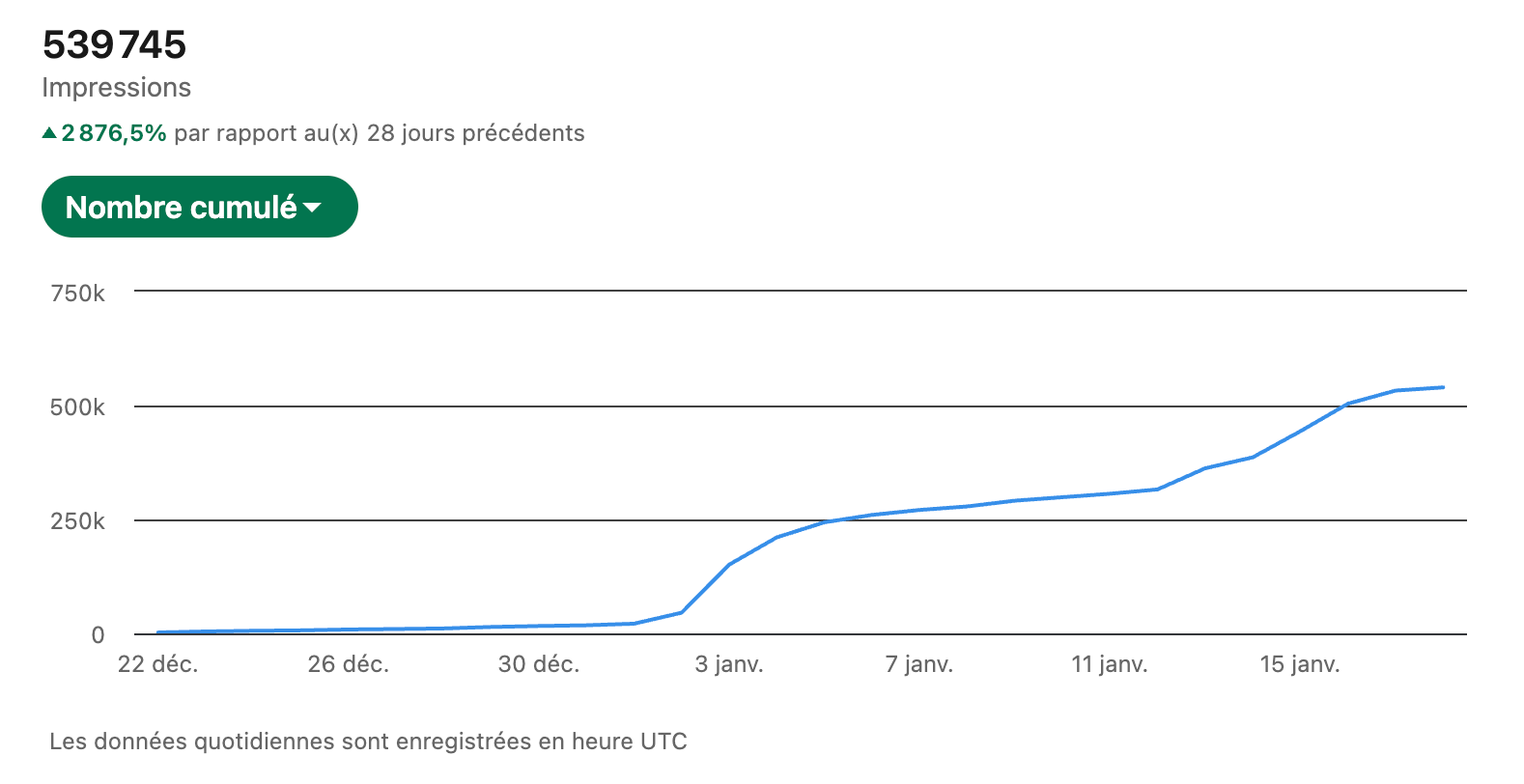

📊 Backstage

Cette semaine, j'ai décidé de rendre public l'intégralité du protocole que j'utilise pour produire mes articles au quotidien, ainsi que cette newsletter hebdomadaire.

Pourquoi ? Parce que la transparence sur les méthodes de travail est un pilier de la déontologie journalistique. Et parce que je pense que c'est une trajectoire pertinente et crédible de ce que peut être une production de contenu accompagnée par l'IA — sans en faire un raccourci ni une boîte noire.

Le principe fondateur : La machine filtre, analyse et propose. L'humain valide, publie et assume. Jamais l'inverse.

Ce que vous y trouverez :

- Le flux de traitement en 9 étapes (de la source brute à la publication validée)

- La charte éditoriale de 313 lignes injectée dans chaque prompt

- La grille de scoring bidimensionnelle (pertinence + qualité documentaire)

- La boucle de feedback qui fait que les erreurs que je commets ne devraient en principe pas se répéter

- Le journal des changements public — chaque modification du protocole est datée et documentée pas à pas.

- L'auto-évaluation face à la Charte de Munich (8/10 devoirs alignés)

Ma ligne éditoriale n'est donc pas une simple déclaration d'intention — c'est désormais une contrainte technique, codée dans l'ADN du projet.

Les patterns interdits sont détectés par regex. Les seuils de publication sont hardcodés. Aucune publication ne sort sans validation humaine explicite. Si je valide une erreur, je n'ai pas d'autre choix que de l'assumer. Et de faire en sorte qu'elle ne se reproduise plus, en faisant en sorte que les systèmes technique et humain continue d'apprendre par boucles d'itération.

Le paradoxe assumé : J'analyse les outils de la Big Tech tout en les utilisant. Mais la charte nomme ce choix : comprendre comment ça marche avant de critiquer. C'est le "First Learn The Rules" appliqué à ma propre pratique.

N'hésite pas à auditer, critiquer, suggérer. Ce protocole est un work in progress permanent, faillible et imparfait. Mais transparent dans ses intentions et dans son mode de fonctionnement.

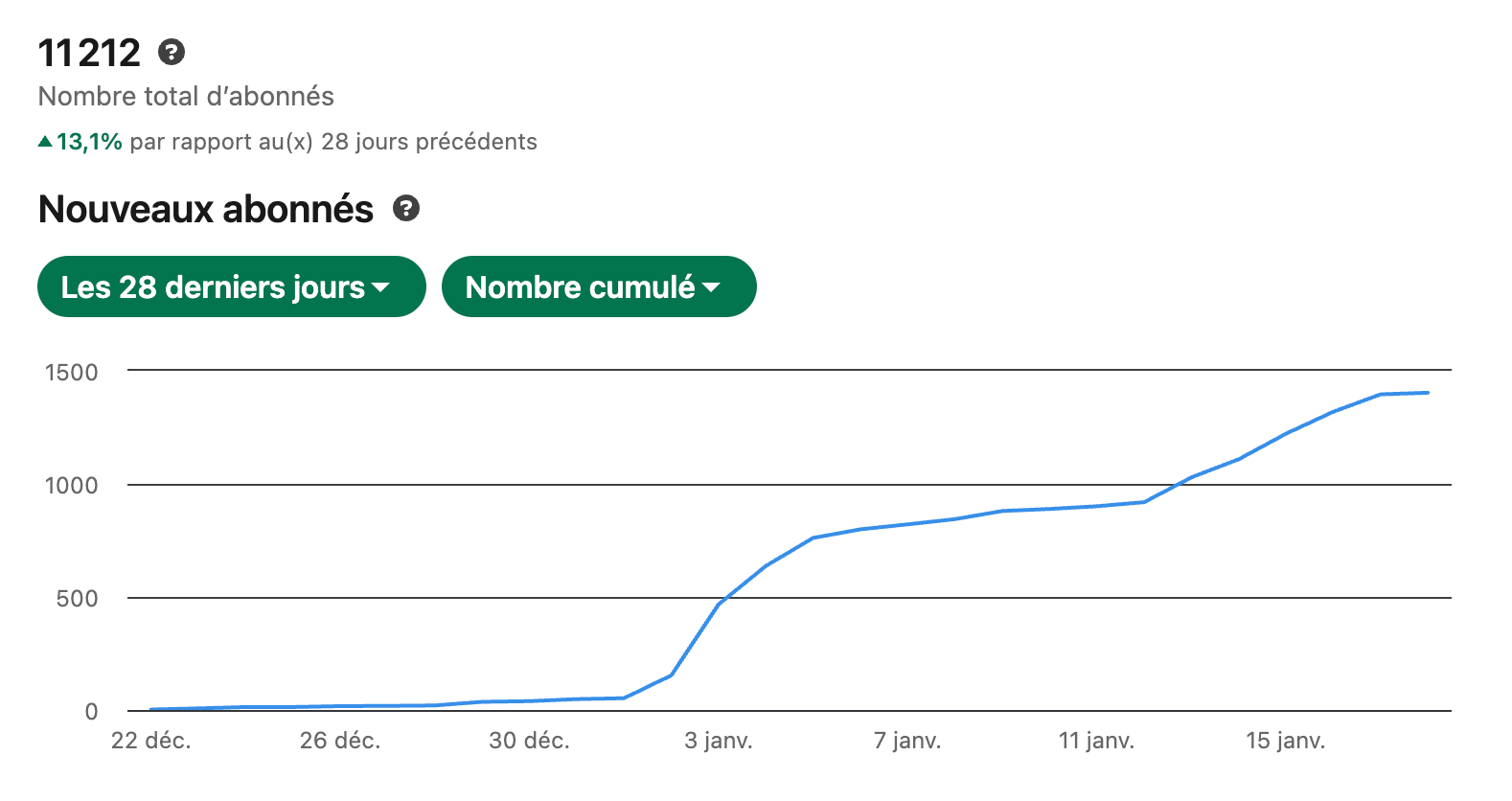

Au-delà des metrics (qui font bien plaisir, je ne vais pas te mentir), c'est surtout toutes ces conversations dans les commentaires, ces petits messages en DM et ces discussions de vive-voix que me confortent et m'encouragent. Sans compter le plaisir que j'ai à bidouiller avec mon ordi et à produire du contenu qui a vraiment du sens pour moi.😎🤘

🙏 Encore merci pour ta confiance !

💬 on en discute ?

Tu veux recevoir le flux quotidien des articles publiés sur le site ?

Suis-moi sur LinkedIn, sur Facebook ou rejoins-moi sur Discord !

Tu as des remarques, des suggestions, ou tu veux discuter d'une idée pour avancer dans tes propres projets ? Réponds directement à ce mail ou jette un oeil à mon agenda. 📆

À dimanche prochain !

Damien

N'hésite pas non plus à consulter les autres éditions de cette newsletter pour retrouver tous les liens, les pistes d'actions et les coulisses de mes projets des semaines précédentes.

À dimanche prochain,

Damien