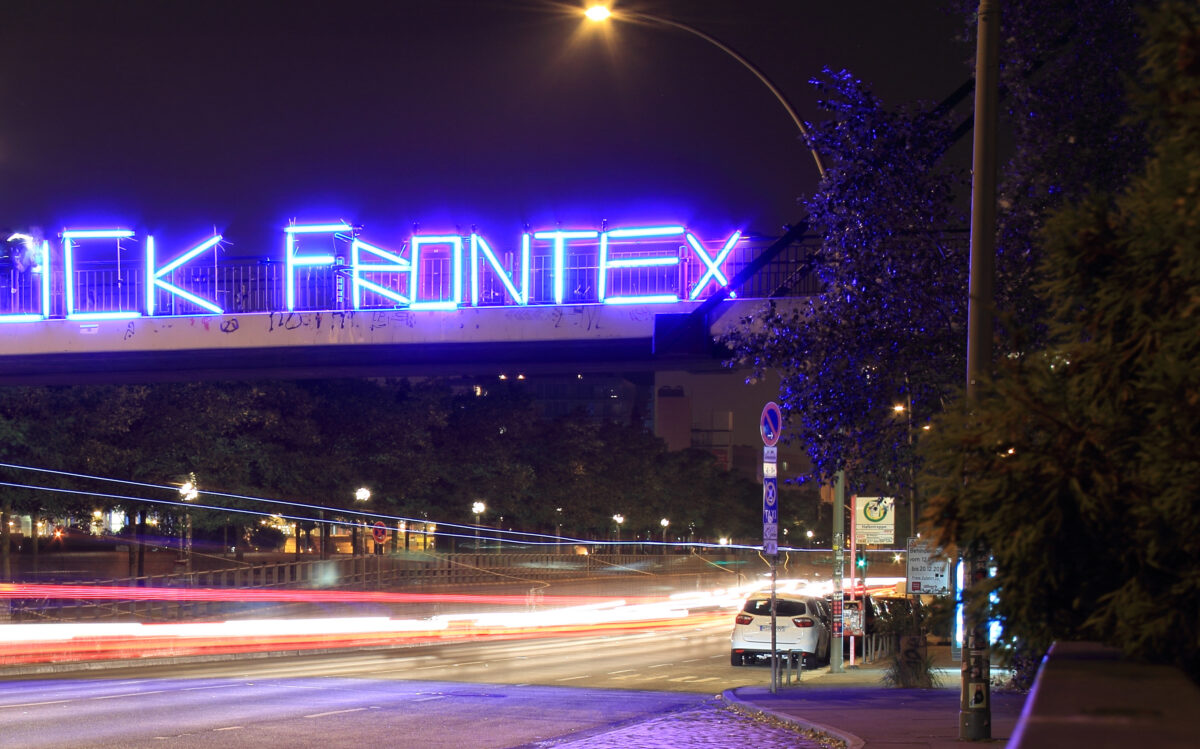

Cette révélation d'AlgorithmWatch dévoile une logique implacable : Frontex investit 500 000 euros dans une application mobile équipée d'un chatbot IA pour faire du conseil en expulsion à échelle industrielle. Le cynisme du dispositif frappe par sa sophistication technique mise au service de l'euphémisation bureaucratique. En 2025, les conseillers Frontex ont déjà mené 17 809 sessions dans 15 pays, obtenant 42% de 'déclarations de retour volontaire' — un taux d'efficacité que l'IA pourrait démultiplier.

"Développer un cadre théorique plus solide pour soutenir l'argument selon lequel l'accès à l'information augmente le taux de retours volontaires [traduit de l'anglais]"

— Bureau des droits fondamentaux, Frontex

Le chatbot, entraîné uniquement sur des données en anglais mais capable de répondre en arabe, ourdou et pachto, incarne une asymétrie technologique révélatrice : l'Europe automatise ses rejets dans les langues de ceux qu'elle expulse. Plus troublant encore, le Bureau des droits fondamentaux de Frontex a validé le projet sans évaluation d'impact, considérant qu'un système dispensant des 'conseils juridiques' automatisés ne constituait pas un 'usage à haut risque' de l'IA. Cette normalisation de l'assistance algorithmique à l'expulsion révèle comment la technologie peut industrialiser la violence d'État sous couvert de modernisation des services publics.

Points de vigilance

Risque de normaliser l'automatisation de décisions affectant les droits fondamentaux sous couvert d'efficacité administrative. L'absence d'évaluation d'impact crée un précédent dangereux pour d'autres usages 'à faible risque' de l'IA dans les politiques migratoires.

Et maintenant ?

- 🤘 Organiser un audit citoyen des algorithmes de Frontex via des FOIA coordonnées

Coalition AlgorithmWatch + EDRi + organisations de défense des migrants pour multiplier les demandes d'accès aux documents sur tous les projets de digitalisation Frontex. Créer une base de données publique des algorithmes utilisés dans les politiques migratoires européennes, forçant la transparence par saturation administrative.

→ On saura que ça marche quand Frontex sera contrainte de publier proactivement ses évaluations d'impact algorithmique pour éviter les vagues de FOIA.

- 🤘 Créer un réseau européen de fact-checking des 'conseils juridiques' automatisés

Réseau d'avocats spécialisés en droit migratoire + ONG pour documenter les erreurs et biais des chatbots institutionnels dispensant du conseil juridique. Produire des contre-expertises publiques sur chaque conseil automatisé, créant une jurisprudence de la responsabilité algorithmique en droit des étrangers.

→ On saura que ça marche quand les tribunaux reconnaîtront la responsabilité des institutions pour les conseils erronés de leurs chatbots.

- 💪 Documenter et partager les interactions avec les chatbots institutionnels

Créer un protocole de documentation systématique des échanges avec les chatbots administratifs : capture d'écran horodatée, sauvegarde des conseils reçus, signalement des incohérences. Alimenter une base collective de preuves sur les défaillances algorithmiques dans l'action publique.

→ On saura que ça marche quand les administrations devront justifier publiquement les conseils dispensés par leurs algorithmes face à une jurisprudence documentée.

8/10 : Score sur l'échelle des "5 piliers de la liberté", inspiré de l'ouvrage de Timothy Snyder

Ces pistes ne sont pas des recettes toutes faites, mais des points d'entrée pour repenser nos systèmes numériques selon une logique de liberté positive : non pas limiter, mais augmenter nos capacités collectives d'action.

Si tu connais des exemples réels qui vont dans ce sens — ou des contre-exemples qui méritent d'être documentés — partage-les en commentaires et discutons-en ensemble sur Discord !