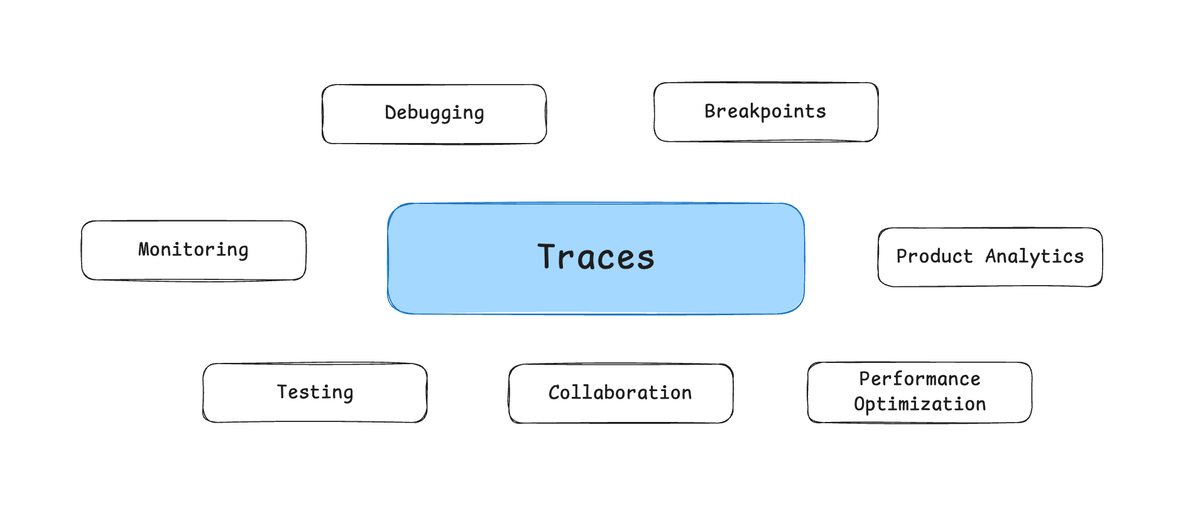

Cette analyse technique révèle un basculement architectural majeur : avec les agents IA, la logique applicative migre du code source (lisible, déterministe) vers les modèles de langage (opaques, non-déterministes). Le développeur perd sa capacité traditionnelle d'audit et de contrôle. Là où on lisait une fonction handleSubmit() pour comprendre un bug, il faut désormais analyser des 'traces' d'exécution pour comprendre les décisions prises par l'agent. Cette transformation crée une dépendance structurelle aux plateformes d'observabilité et aux fournisseurs de modèles.

Plus inquiétant : le débogage, les tests et l'optimisation ne peuvent plus se faire sur le code mais sur des traces d'exécution, introduisant une couche d'intermédiation opaque. On observe ici l'émergence d'une nouvelle forme de vendor lock-in : celui des outils de traçabilité et d'observabilité, devenus indispensables pour maintenir une visibilité minimale sur ses propres applications.

Points de vigilance : Risque de normalisation de l'opacité sous prétexte d'innovation technique. La dépendance aux outils de traçabilité peut créer un nouveau vendor lock-in plus subtil que les précédents.

9/10 : Score sur l'échelle des "5 piliers de la liberté", inspiré de l'ouvrage de Timothy Snyder

Et maintenant ?

🤘 Imposer des standards ouverts d'observabilité pour les agents IA

Coalition régulateurs + développeurs + chercheurs pour définir des formats standardisés de traces d'agents, évitant le vendor lock-in des outils d'observabilité. Inspiration : standards OpenTelemetry pour le monitoring traditionnel, mais adapté aux décisions algorithmiques.

→ On saura que ça marche quand les traces d'agents pourront être exportées et analysées sur n'importe quelle plateforme, comme on peut aujourd'hui déboguer du code sur différents IDE.

🤘 Créer des certifications d'auditabilité pour les systèmes d'agents

Alliance assureurs + auditeurs + entreprises pour exiger des garanties d'explicabilité sur les agents critiques. Mécanisme : certification obligatoire prouvant qu'on peut reconstituer et expliquer les décisions d'un agent a posteriori.

→ On saura que ça marche quand les agents non-auditables seront exclus des secteurs critiques (finance, santé, justice) comme le sont aujourd'hui les logiciels non-certifiés.

💪 Exiger la portabilité des traces avant d'adopter un outil d'agents

Conditionner tout déploiement d'agents à la capacité d'exporter ses traces dans un format standard. Créer un effet de réseau : plus les développeurs exigent cette portabilité, plus les fournisseurs sont contraints de l'implémenter pour rester compétitifs.

→ On saura que ça marche quand 'export des traces' deviendra un critère standard d'évaluation des plateformes d'agents, comme 'export des données' l'est devenu pour les SaaS.

Ces pistes ne sont pas des recettes toutes faites, mais des points d'entrée pour repenser nos systèmes numériques selon une logique de liberté positive : non pas limiter, mais augmenter nos capacités collectives d'action.

Si tu connais des exemples réels qui vont dans ce sens — ou des contre-exemples qui méritent d'être documentés — partage-les en commentaires et discutons-en ensemble sur Discord !

Cinq piliers pour prendre soin de nos libertés numériques